GPT4All: How to run "ChatGPT" locally on your PC, Facebook/Meta has ignited the open-source uncensored GPT community, what an irony 🚀

So könnt ihr "ChatGPT" lokal auf eurem PC betreiben, Facebook/Meta hat die Open-Source GPT Bewegung mit unzensurierten Modellen entfacht 🚀

Ende Februar hat Meta LLaMA (Large Language Model Meta AI) für wissenschaftliche Zwecke veröffentlicht, eine Serie von Sprachmodellen in unterschiedlichen Größen. Diese reichen von 7 Milliarden für das kleinste Modell bis 65 Milliarden Parameter. Zum Vergleich ChatGPT soll mit 175 Milliarden Parameter trainiert worden sein.

Es dauerte nicht lange und die LLaMA-Modelle wurden ins Internet geleakt und von der Stanford Universität (Alpaca) und der Open-Source-Community aufgegriffen und mit Antworten von ChatGPT weiter trainiert.

Mittlerweile ist es möglich, die kleineren auf LLaMA-basierte Modelle sogar lokal auf dem PC zu betreiben.

Und das Beste ist, es gibt auch Modelle, die nicht zensuriert sind. Yeah, endlich.

Allerdings gibt es auch einen Hacken, die Large Language Modelle brauchen enorm viel VRAM (unter 12 GB kann man es eher vergessen) und die kleineren Open-Source-Modelle sind noch ziemlich doof und deutlich schwächer als ChatGPT / GPT-4 und in der Praxis im Moment kaum verwendbar, da sie so viele Fehler machen oder sogar in Endlosschleifen stecken bleiben und immer denselben Text erzeugen.

Aber die Open-Source-Modelle werden immer besser und entwickeln sich rasend schnell weiter. Fast jeden Tag wird ein neues Modell veröffentlicht, das ein bisschen besser ist oder eine Nische abdeckt.

So könnt ihr die LLaMA Modelle lokal auf eurem PC ausführen

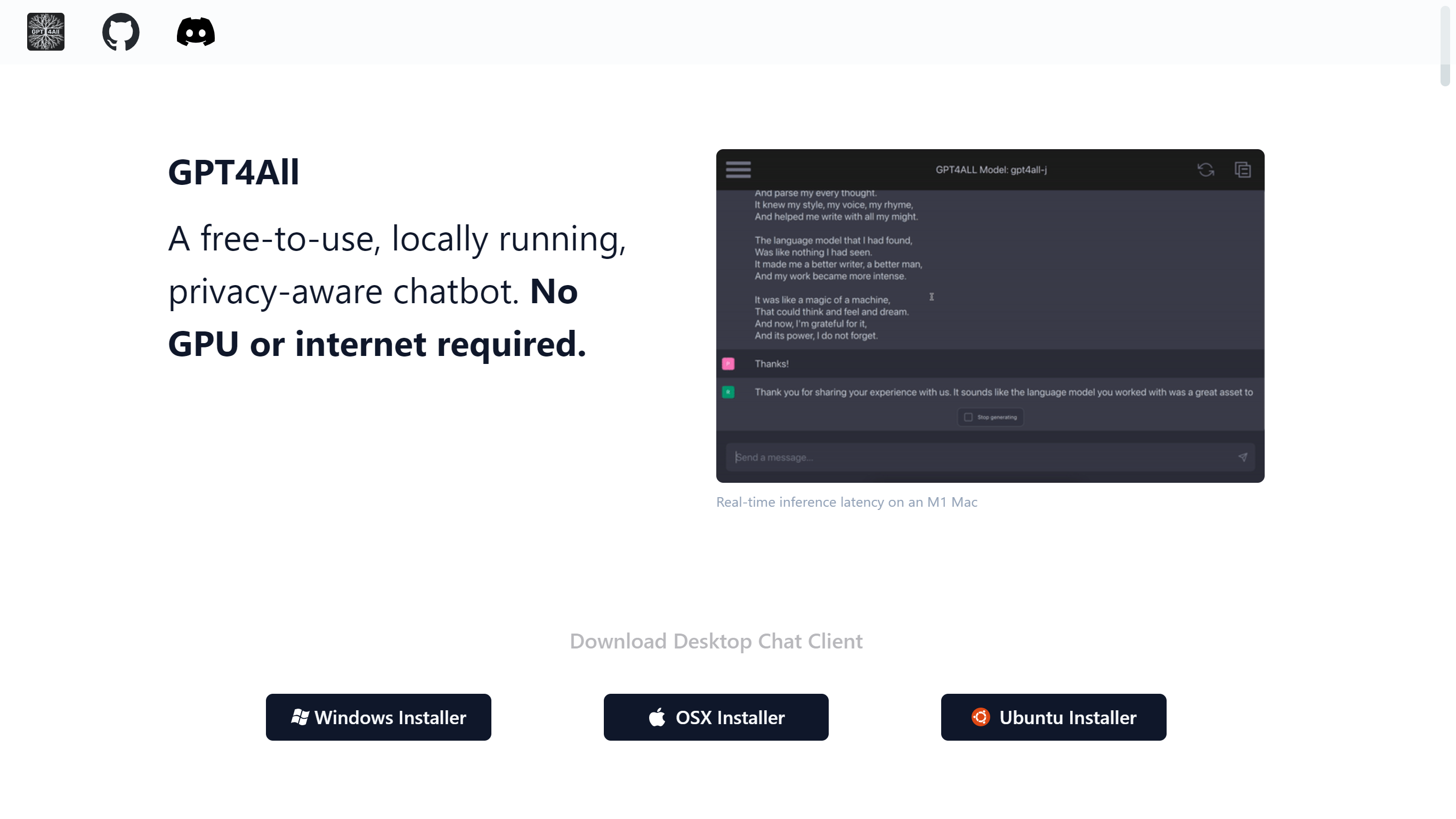

Eines der Interfaces, das sich unter Windows am einfachsten installieren lässt, ist GPT4All.

https://github.com/nomic-ai/gpt4all

Einfach den Windows Installer ausführen und dann GPT4All starten und ein Modell auswählen und herunterladen und loslegen. Es ist keine GPU notwendig, die Berechnung findet auf der CPU statt und es sind circa 8 GB RAM für die kleinsten 7B Modelle notwendig.

Voilà.

Ein weiteres LLM-Interface, das sich etabliert hat, ist Oobabooga, das allerdings etwas aufwendiger zum Installieren ist.

https://github.com/oobabooga/text-generation-webui

Eine ausführliche Installations-Anleitung findet ihr auf dem Channel von Aitrepreneur.

Was sagt ihr dazu, dass man dank Facebook und der Open-Source-Community LLMs in der Zwischenzeit sogar lokal am PC betreiben kann? Habt ihr es schon ausprobiert?

GPT4All

Oobabooga (Installation guide)

Video credit: Aitrepreneur

mpt-47b-chat Demo

Q

What is the Hive Blockchain?

A (mpt-47b-chat)

The Hiive blockchain is a decentralized, secure and transparent platform for verifying identity and managing personal data. It allows individuals to take control of their digital identity by creating a unique digital identity that is verified through biometric authentication. The Hiive blockchain provides a tamper-proof record of all identity verification activities, ensuring that personal information is kept safe and secure.

Q

solve the puzzle: When I was 6 my sister was half my age, now i'm 70. How old's my sister?

A ( mpt-47b-chat)

Your sister is currently 50 years old.

Result

Both answers are terribly wrong and the 7B model also misspelled "Hiive" 🙈 ChatGPT can solve both prompts btw.

English

This is how you can run "ChatGPT" locally on your PC, Facebook/Meta has sparked the open-source GPT movement with uncensored models 🚀

In late February, Meta released LLaMA (Large Language Model Meta AI) for scientific purposes, a series of language models in different sizes. These range from 7 billion for the smallest model to 65 billion parameters. For comparison, ChatGPT is said to have been trained with 175 billion parameters.

It wasn't long before the LLaMA models were leaked to the Internet and picked up by Stanford University (Alpaca) and the open source community and further trained with responses from ChatGPT.

Meanwhile, it is possible to run the smaller LLaMA-based models even locally on a PC.

And the best thing is, there are also models that are not censored. Yeah, finally.

However, there is also a hitch, the large language models need an enormous amount of VRAM (below 12 GB you can rather forget it) and the smaller open source models are still pretty dumb and much weaker than ChatGPT / GPT-4 and in practice hardly usable at the moment, because they make so many errors or even get stuck in infinite loops and always generate the same text.

But the open source models are getting better and better and evolving rapidly. Almost every day a new model is released that is a little bit better or covers a niche.

How to run the LLaMA models locally on your PC

One of the interfaces that is easiest to install on Windows is GPT4All.

https://github.com/nomic-ai/gpt4all

Just run the Windows installer and then run GPT4All and select and download a model and get started. No GPU is needed, the computation is done solely on the CPU and about 8 GB of RAM is needed for the smallest 7B models.

Voilà.

Another LLM interface that has become established is Oobabooga, but it is a bit more complex to install.

https://github.com/oobabooga/text-generation-webui

You can find a detailed installation guide on the channel of Aitrepreneur.

What do you think about the fact that thanks to Facebook and the open source community you can run LLMs locally on your PC in the meantime? Have you already tried it out?

Live your Secrets and Hive Prosper 🍯

xx Viki @vikisecrets

Posted with STEMGeeks

I didn't try it, if it comes from Facebook it makes me a little reticent, but I'll try it.

Cui bono?

Für Firmen, damit keine Sensiblen Daten im Internet Anden sondern nur im Firmennetzwerk? Wäre meine Vermutung.

Firmen haben ja die Nutzung deswegen bereits untersagt, da dadurch Firmengeheimnisse schon gelenkt wurden. !LOL

lolztoken.com

but I’ve quit smoking loads of times.

Credit: marshmellowman

@stayoutoftherz, I sent you an $LOLZ on behalf of @mein-senf-dazu

(1/4)

Use the !LOL or !LOLZ command to share a joke and an $LOLZ

Mit sensiblen Daten meinst Du die Suchabfragen? Möglich.

Ich meinte generell, nichts ist umsonst. Wenn ein Konzern wie Meta etwas "umsonst" zur Verfügung stellt, sollten alle Alarmglocken angehen!

Ja genau in den suchen wurden u.a. Code verwendet der Quasi Firmengeheimnis war.

Naja die großen machen öfters manches Open Source. Das ist soweit ich weiß gar nicht selten.

Meta hat die Modelle nur bedingt freiwillig hergegeben: sie haben die Modelle nur mit Forschern geteilt, von dort aus haben die Modelle den Weg ins Internet gefunden (aka Leak). Soweit ich weiß gibt es keinen offiziellen öffentlichen Downloadlink, um die Modelle herunterzuladen muss man ein wenig suchen.

Von den Weiterentwicklungen der Open-Source-Community kann auch Facebook wieder profitieren. Man kann es auch als Auslagerung der Entwicklung sehen, um den Anschluss zu Microsoft und Google nicht zu verlieren und gleichzeitig ist es extrem gut für das Firmenimage.

You mentioned how LLaMA models run locally on PC and wrote beautifully about ChatGPT.

Is it RAM or VRAM that the large language models need?

I have 128Gb RAM but no VRAM

The cool thing is, you can run the models both on the GPU and CPU, and also split the inference between them, so preferably on GPU, because it's much faster, but it's possible to run the entire model on the CPU RAM only.

I have not tried it before but I was interesting to use it because I have listened about it from my sister that now it's very famous to use.

!BBH

@vikisecrets! Your Content Is Awesome so I just sent 1 $BBH (Bitcoin Backed Hive) to your account on behalf of @thehockeyfan-at. (1/1)

Kein Platz auf der Festplatte für. Brauch mal eine größere.

I have heard a lot aboy ChatGPT but never tried to use it. Perhaps my anxiety about new technology stops me.

Currently, AI is not that smart but I am sure people are ready to become dumb.

Just ran it on a Macbook Pro with M1 Max CPU and 64 Gb RAM.

Very fast. Much faster than Intel i7 6800k with 128Gb RAM in Windows.

Not sure whether it is very smart though.

On my Windows machine it gave a good answer on Hive with no misspelling.

On Mac it gave a mixed up answer with a mis-spelling.

Have you tried the different downloadable models?

Where can you download the bigger, less stupid ones?

One of the best models so far is the Vicunia 13b model, will do a post about different models, they are usually published on huggingface.co

Very cool information, thanks! I'm going to have to give it a try!

I am waiting for the day when I can connect one of these ias to my social media accounts so that they can help me answer the messages from my online businesses, most of the clients arrive through Facebook and Instagram and they almost always ask the same questions, I want train an AI to help me answer them all

Haha, good use case 😆

for me, that could be very useful that way!

Ich hab's ausprobiert, die Ergebnisse sind aber sehr bescheiden. "ChatGPT" lokal laufen zu lassen klingt zwar cool, die Performance von LLaMA ist aber meilenweit von der von ChatGPT entfernt (zumindest in den Modellen, die ich zum Laufen gebracht habe).

yep, die Modelle sind noch viel schwächer als ChatGPT, aber wenn die Entwicklung so weitergeht, werden wir vielleicht in ein paar Monaten richtig gute lokale Modelle haben. Ist unglaublich.

Vielleicht, bin da auch gespannt.

I like the open-source part but it looks like the accuracy of ChatGPT leaves a lot to be desired though.

Für Unternehmen sicher eine sehr gute Alternative! :D